På udviklerkonferencen WWDC præsenterede Apple alle de nye funktioner i sine operativsystemer til mobile enheder og computere. Men helt frem til en time inde i åbningstalen havde de stadig ikke sagt det ord, de så omhyggeligt har undgået det seneste år: AI.

Noget, der ikke er gået ubemærket hen hos analytikere, pressen eller brugerne. I mellemtiden har Microsofts Copilot gjort store fremskridt takket være OpenAI og deres ChatGPT, Googles Gemini fejrer nye triumfer, og ærkefjenden Samsung har lanceret sin Galaxy AI med praktiske mobilfunktioner. Hvad har Apple gang i, har alle undret sig over. Har de gang i noget revolutionerende, som vil overhale deres konkurrenter, eller har de bare misset toget?

Så trådte Tim Cook endelig frem på scenen og præsenterede Apple Intelligence. For selvfølgelig skal Apple have sin egen term for at få det til at lyde som noget helt for sig selv. Og hvad var det så egentlig, at Apple viste frem?

For det første er Siri endelig blevet brugbar. Det vil sige, at den forstår, hvad man siger, og rent faktisk kan være til nytte.

Her har Apple en stor fordel, eftersom operativsystemet har adgang til alle dine personlige oplysninger, dine beskeder, dine e-mails, din kalender og dine fotos. Derfor kan den gøre rigtig brugbare ting som at forstå, at det er den samme person, der har sendt en besked og en e-mail, og finde de informationer, du leder efter. Eller forstå sammenhængen mellem personer, tidspunkter og steder i kalenderen. Dette er en killer-app, som konkurrenterne aldrig vil kunne matche, medmindre du slipper dem ind i mobilen og lader oplysningerne blive uploadet online. Et mareridt for privatlivets fred.

Men det, de slår på tromme for, er funktioner som hjælp til at skrive. Altså at kunne læse korrektur, omformulere, ændre tonen i teksten, opsummere tekst eller lave punktopstillinger til præsentationer. Men det er jo præcis, hvad konkurrenterne har gjort i et stykke tid nu, så det føles næppe revolutionerende. Det samme gælder persongenkendelse i fotos og fotoredigeringsfunktioner, der har eksisteret længe i Google Fotos.

Og så kører det helt af sporet. “AI kan hjælpe dig med at lave emojis”. Og hvad så? Hvem har efterspurgt det? Skolebørn? Nu kan den ganske vist også generere billeder, men det føles som en fesen kopi af konkurrenter som ImageFX.

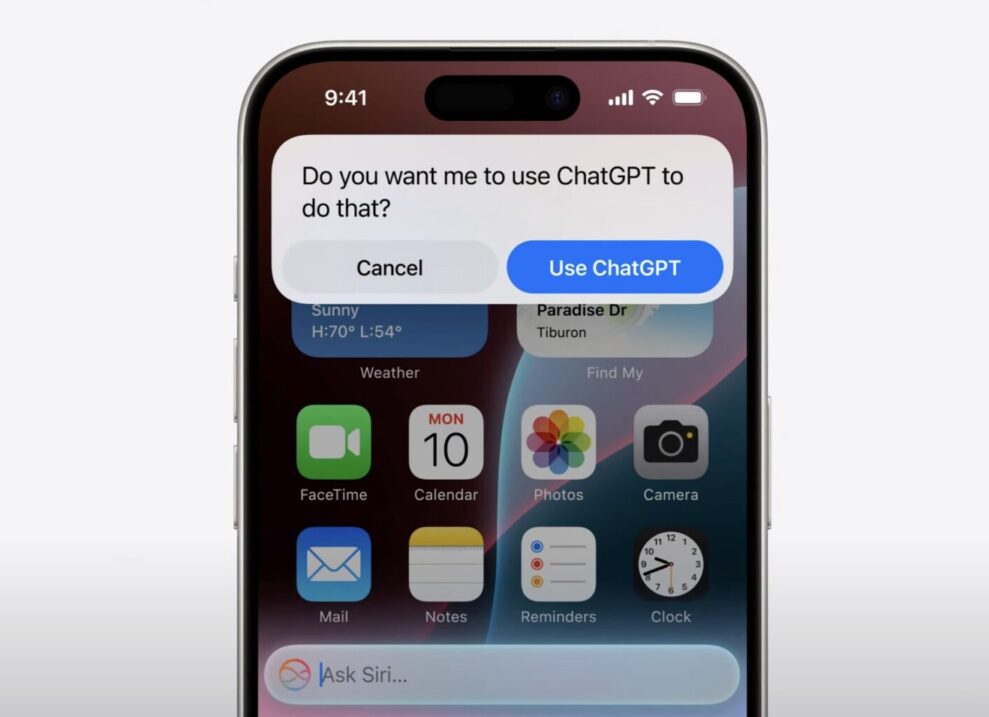

Og så fik vi endelig at vide, hvad samarbejdet med ChatGPT, som der har verseret mange rygter om, egentlig gik ud på. Ville det blive en “Siri powered by OpenAI”? Nej, det blev i stedet en tjeneste, som Siri henviser til, når man stiller spørgsmål, som den ikke kan svare på. Med andre ord det modsatte af noget integreret og Steve Jobs’ beskrivelse af Apples designfilosofi “It just works”. Det føles ikke som Apple, men i stedet som noget, der er tapet sammen med gaffatape ugen før præsentationen.

Det modsatte af, hvad Elon Musk er begyndt at råbe op om. Nej, Elon, se præsentationen. Apple sender absolut ikke dine personlige oplysninger til ChatGPT. Det er derfor, de er tvunget til at stille spørgsmålet “Vil du have, at jeg spørger ChatGPT om det?”. På den måde kan de holde deres løfte om, at når du bruger et Apple-produkt, bekymrer de sig om dit privatliv.

Så hvordan vil Apple løse dette? De er selvfølgelig nødt til at have deres egen private cloud-løsning med sprogmodeller. Noget, som de i forbifarten under præsentationen faktisk fortalte os, at de har. Private Cloud Compute bruges, når dit spørgsmål er for kompliceret til at kunne besvares på din enhed. Men de er nødt til at gøre som konkurrenterne og træne den i al information på nettet, så den kan svare på alt. Det er dog åbenbart så langt ude i fremtiden, at de har været nødt til at satse på ChatGPT så længe.

Nu er Apple Intelligence ganske vist ikke blevet frigivet endnu. Den kommer “senere på året”. Så måske skal vi ikke dømme dem for hårdt, før vi rent faktisk kan teste det selv. Men de har ikke ligefrem udraderet konkurrenterne.

Læs også:

Et væld af nye funktioner i Apples operativsystem

Næste år kan Android- og iMessage-brugere endelig kommunikere på lige fod.